Sicher hast Du schon von der statistischen Signifikanz, von einem Signifikanztest oder sogar von der Teststärke oder Power eines Tests gehört. Vielleicht hast Du auch schon selbst Signifikanztests durchgeführt und sogar schon beim Beschreiben Deiner Ergebnisse von „statistisch signifikant“ gesprochen.

Aber was genau bedeutet das? Und wie hängen Signifikanz und Teststärke zusammen?

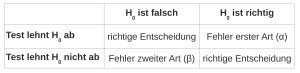

Bei einem Signifikanztest wird eine Testentscheidung getroffen:

- signifikanter p-Wert: Nullyhypothese wird abgelehnt oder

- nicht signifikanter p-Wert: Nullhypothese wird nicht abgelehnt.

Diese Entscheidung kann falsch sein. Das nennt man Fehler beim statistischen Testen.

Es gibt zwei Arten von Fehlern beim statistischen Testen:

- Fehler 1. Art oder alpha-Fehler

- Fehler 2. Art oder beta-Fehler

Du willst mehr Durchblick im Statistik-Dschungel?

Der Fehler 2. Art tritt ein, wenn die Nullhypothese in Wahrheit falsch ist, der Test sie aber nicht ablehnt. Der Test sagt also, es gibt keinen signifikanten Unterschied oder Zusammenhang, obwohl es in Wahrheit einen gibt.

Der Fehler 1. Art (alpha) wird mit dem Signifikanzniveau kontrolliert. Das Signifikanzniveau wird meist mit 5 % (0,05) festgesetzt. Also wird ein p-Wert kleiner 0,05 als signifikant angesehen. Das bedeutet, man erlaubt sich bei diesem Test einen Fehler 1. Art in maximal 5 % der Fälle.

Der p-Wert wird von der Statistiksoftware direkt als Testergebnis ausgegeben. Basierend auf ihm wird die Entscheidung für oder gegen die Nullhypothese getroffen.

Der Fehler 2. Art (beta) wird normalerweise nicht direkt beim Testergebnis ausgegeben, lässt sich aber nach dem Test berechnen, z.B. mit der freien Software G*Power der Uni Düsseldorf.

Der Wert 1-beta wird auch Power oder Teststärke genannt. Die Teststärke ist ein Maß für die Fähigkeit des Tests, einen Unterschied bzw. Zusammenhang als signifikant nachzuweisen. Ab 80 % (beta < 0,2) wird meist von einer guten Teststärke gesprochen.

Ich bin Statistik-Expertin aus Leidenschaft und bringe Dir auf leicht verständliche Weise und anwendungsorientiert die statistische Datenanalyse bei. Mit meinen praxisrelevanten Inhalten und hilfreichen Tipps wirst Du statistisch kompetenter und bringst Dein Projekt einen großen Schritt voran.

Liebe Daniela,

ich habe zwei Varianzanalysen gerechnet und folgende Werte bekommen:

A: F(1, 184) = 10.79, p = .001, partielles η2 = .23

B :F(2, 184) = 1.19, p = .308, partielles η2 = .013.

C: F(2, 184) 0.56, p = .570, partielles η2 = .006.

Nun ist A hochsignifikant und weißt eine hohe Effektstärke auf. B ist nicht signifikant hat auch kaum Effektstärke. C ist schon vom Prinzip her nicht signifikant, da F < 1 ist.

Für A habe ich mit G'Power eine Teststärke von 100% (geht das überhaupt oder ist das gerundet?) bekommen. Für B beträgt die Teststärke knapp 81% und C rund 46 %.

Wie kann ich diese Ergebnisse berichten? Reicht es zu sagen, dass A eine hohe Teststärke mit einer Wahrscheinlichkeit von beta < .001 (1-beta = 99.9%) kein beta-Fehler vorliegt? Und bei B bin ich mir jetzt nicht sicher. Ich lehne H0 ab, da das Ergebnis der ANOVA nicht signifikant ist. Sollte ich bei diesem kleinen Effekt überhaupt die Teststärke berichten und was wäre die Schlussfolgerung.

Danke für Ihre tolle Seite

Patrick Schneider

Hallo Patrick,

das hängt auch davon ab, welches Ziel Du mit der Poweranalyse verfolgst. Wozu rechnest Du sie?

Schöne Grüße

Daniela

Hallo Daniela,

ich würde mich sehr freuen, wenn Sie mir weiterhelfen können:

wenn ich eine gerichtete Hypothese habe, dann muss ich doch einen einseitigen T-Test machen, oder? Aber SPSS testet nur zweiseitig. Wie gehe ich am besten vor: den p-Wert halbieren oder Signifikanzniveau von 95% auf 99% ?

Herzlichen Dank im Voraus

Bini

Hallo Bini,

der p-Wert wird dann halbiert. Allerdings bin ich mit einseitigem Testen vorsichtig. Meiner Ansicht nach dürfte nur einseitig getestet werden, wenn der Unterschied in die andere Richtung völlig unmöglich ist.

Weitere Fragen könnt Ihr gern in meiner Facebook-Gruppe Statistikfragen https://www.facebook.com/groups/785900308158525/ diskutieren.

Schöne Grüße

Daniela

Hallo Daniela,

ich habe folgende Frage: Ich korrigiere die Alpha-Fehlerwahrscheinlichkeit bei drei Einzelvergleiche (t-Test für abhängige Stichprobe) von 0.005 / 3, sodass die korrigierte Überschreitungswahrscheinlichhkeit p < 0.0167 entspricht. Muss ich nun die Beta-Fehlerwahrscheinlichkeit auch nochmal nachkorrigieren, wenn die Alternativhypothese meine Wunschhypothese ist? Grundsätzlich gehe ich von Alpha-Fehler = 0.05; Beta-Fehler = 0.20 aus. Um die Teststärke post hoc in G*Power zu bestimmen, würde ich das Alpha auf 0.0167 setzen und prüfen ob die Power größer/gleich 0.80 ist.

Schon mal herzlichen Dank im Voraus! Grüße, Florian

Hallo Florian,

interessiert dich die Power insgesamt oder für jeden einzelnen Test? Ist letzteres der Fall, dann verwendest du sie wie beschrieben. Wozu benötigst du die Power genau? Hast du nicht signifikante Ergebnisse?

Schöne Grüße

Daniela

Hallo Frau Keller,

beim Chi-Quadrat-Test (zweiseitig) konnte H0 nicht verworfen werden.

Mit g*power habe ich nunh folgende Auswertung vorgenommen:

chi-quadrat

goodnes of fit

post hoc

w=0,0081 (Wurzel aus Wert chi-quadrat / N)

alpha=0.05

Ergebnise:

critical-chi-quadrat=3,841

Power=0,05

wie kann ich diese Ergebnisse nun interpretieren?

Vielen Dank für eine kurze Antwort und schöne Grüße

Sabrina

Hallo Sabrina,

mit 0,05 ist die Power sehr klein (gut wäre 0,8). Die Power ist also zu klein, um den Effekt als signifikant nachzuweisen.

Schöne Grüße

Daniela

ja gut dann teste ich eben 254 Personen und hab dann dafür einen sehr kleinen Alpha und beta fehler. Es tut mir leid Ich glaube ich habe da irgendwo einen Denkfehler bis jetzt verstehe ich den Sinn der Poweranalyse nicht so wirklich. Ich weiß zwar dass bei großen Stichproben für die Praxis irrelevante Unterschiede oder Zusammenhänge signifikant werden und bei kleinen Stichproben bereits für die Praxis relevante Unterschiede oder Zusammenhänge schwieriger signifikant werden. und um dem aus den Weg zugehen kommt die Poweranalyse ins Spiel oder?? Könnten Sie mir Bitte dies irgendwie erklären (und welche Rolle dann auch Alpha und Beta Spielt)

Achso ich dachte weil ja cohens d

0.2 kleine Effektstärke

0.5 mittlere

0.8 große Effektstärke bedeutet kann die Effektstärke nur zwischen 0 und 1 liegen.

Danke für Ihre Antwort

Liebe Grüße..

Hallo Marlene,

die Poweranalyse dient dazu, nach einem Test herauszufinden, wie groß die Teststärke im Test war. Die Fallzahlplanung dient dazu, vor einer Analyse herauszufinden, wie groß die Stichprobe sein muss, um einen bestimmten Effekt mit festgesetzten Werten von Alpha und Power als signifikant nachzuweisen.

Bei kleinerem Alpha und größerer Power wird jeweils eine größere Stichprobe gebraucht.

Cohens d kann auch Werte über 1 annehmen. Es gibt aber auch Effektstärkemaße, die nicht größer als 1 werden können (z.B. Korrelationskoeffizienten).

Schöne Grüße

Daniela

Liebe Frau Keller,

Ich würde Sie auch gerne um Rat fragen , angenommen man würde den Alpha Fehler auf 0.01 setzen und den Beta Fehler ebenfalls auf 0.01 so wäre die Power des Tests hoch also die Wahrscheinlichkeit mit der H1 richtig zu liegen also einen Effekt zu finden wenn er da ist und auch die Wahrscheinlichkeit mit der H0 richtig zu liegen also zu behaupten es gäbe keinen Effekt bzw. Unterschied zwischen 2 Gruppen. könnte man nicht im Allgemeinen von dieser Konvention für die beiden Irrtumswahrscheinlichkeiten ausgehen?

Vielen Dank im Voraus für Ihre Antwort.

Liebe Grüße

Marlene

Liebe Marlene,

das wären Traumwerte 🙂 Wenn du dir diese Werte aber als Grenzen setzt, wirst du in der Praxis nur ganz selten zu aussagekräftigen Ergebnissen kommen. Du würdest ja dann nur Ergebnisse mit sehr kleinem p-Wert und sehr großer Power als verlässlich einstufen. Das hat man eben nicht oft.

Schöne Grüße

Daniela

mhh kompliziert… könnten Sie bitte hierfür vielleicht ein praktisches Beispiel nennen wo dies ersichtlich wird?? Und was ich Sie noch fragen wollte hat die Effektstärke den Wertebereich von 0-1??

vielen vielen Dank für Ihre Antwort

Liebe Grüße

Marlene

Beispiel aus einer Fallzahlplanung: Um eine erwartete Korrelation von 0.3 (das ist eine mittelstarke Korrelation) mit einem Signifikanzniveau von 0.01 und einer Power von 0.99 als signifikant nachzuweisen ist eine Fallzahl von mindestens 254 erforderlich. Wenn man eine kleinere Stichprobe hat kann man unter diesen Umständen die Korrelation also nicht als signifikant nachweisen, obwohl die Korrelation mittelstark ist. (alles berechnet mit G*Power)

Und nein, die Effektstärke liegt nicht immer zwishen 0 und 1. Es kommt auf das Effektstärkemaß an.

Schöne Grüße

Daniela

Hallo Frau Keller,

Danke für Ihre hilfreichen Informationen.

Ich stoße leider auf eine Frage, die sich durch die Literatur für mich nicht ganz klärt.

Ich nehme in meiner Forschung an, dass KEIN Unterschied zwischen zwei unabhängigen Stichproben besteht. Der entsprechende p-Wert für den t-test ist nicht signifikant (er beträgt 0.5). Nun möchte ich einen a-posteriori-test machen, um mit größerer Gewissheit die H0 annehmen zu können.

Mir ist nicht ganz klar, ob ich in G*Power nun neben der Stichprobengröße und dem erwarteten Effekt das Alpha aus meinem t-test (also ca. 0.5) oder das gängige Alpha von 0.05 eintragen muss?

Ich würde mich über Ihre Antwort sehr freuen.

Viele Grüße

Julia

s. Antwort oben. 🙂 Für den Nachweis, dass sich zwei Mittelwerte nicht unterscheiden, können Sie auch gut Konfidenzintervalle verwenden.

Hallo Frau Keller,

Entschuldigung, ich dachte der erste Kommentar kam nicht durch 🙂 Danke für Ihre Antwort, das hat mir bereits sehr geholfen.

Viele Grüße

Hallo Frau Keller,

ganz herzlichen Dank für Ihre wertvollen Erklärungen. Ich verwende das G*Power Programm bereits, habe aber eine ganz spezielle Frage, wenn es darum geht, eine Nullhypothese zu testen. Meine Annahme ist, dass sich der Mittelwert zweier unverbundener Stichproben nicht unterscheidet. Über SPSS habe ich einen t-test durchgeführt, bei welchem auch tatsächlich ein nicht signifikantes Ergebnis vorzufinden ist, das alpha liegt bei ca. 0.5. Nun möchte ich mithilfe von G*Power testen, ob ich die H0 tatsächlich „annehmen“ kann. Hierfür verwende ich den Post-Hoc-Test, habe die gewünschte Effektgröße eingestellt sowie die Stichprobengrößen eingetragen. Mir ist jedoch nicht ganz klar, ob ich in das Feld Alpha nun die 0.5 aus meinem t-test eintragen muss, oder ein alpha von 0.05 entsprechend dem „normalem“ Signifikanzniveau. Hätten Sie hierzu eine Hilfestellung für mich?

Besten Dank für Ihre Mühe und viele Grüße.

Hallo, Sie möchten die Power berechnen, oder? Sie müssen 0,05 eintragen als alpha.

schöne Grüße

Daniela Keller

Sehr geehrte Frau Keller,

vorgestern hatte ich Ihnen eine Frage in diesem Blog gestellt und da ich sie gekürzt hatte, am Ende versehentlich meinen Dank für Ihre wertvolle website und Tipps nicht mehr eingefügt; das wollte ich hiermit nachholen, denn damit haben Sie mir schon sehr weitergeholfen!

Also, wenn Sie kurz Zeit fänden, auf meine Frage zu antworten, wäre ich Ihnen sehr dankbar!

Viele Grüße

Alina

Hallo Alina,

ich sehe keinen Kommentar von dir im Blog, auch nicht im Spam-Ordner. Kannst du den Kommentar bitte nochmal schreiben?

Danke!

Daniela

Hallo Daniela, vielen vielen dank für deine Antwort! Ich hätte noch eine Frage und zwar kann man ja b/SE (t-Wert) und wenn das Ergebnis größer oder gleich 2 (Daumenregel) ist, ist es signifikant! Gilt dies nur für Pulszahlen oder auch für Minuszahlen (was wäre wenn ich dann -2,5) rausbekomme! Wäre toll wenn du mir das beantworten könntest! Liebe Grüße

Hallo, -2,5 ist auch signifikant: größer 2 oder kleiner -2 ist signifikant. Schöne Grüße Daniela

Danke 😉

Hey Hey, super erklärt danke! ich habe jedoch noch 2 Fragen und zwar was gilt für alpha und beta- Fehler im Signifikanztest? Addieren die sich zu 100, zu 0, sind sie unabhängig oder verhalten sie sich invers zueinander? Und die zweite Frage wäre in welcher Beziehung stehen Signifikannievau alpha und Irrtumswahrscheinlichkeit p? Liebe Grüße

Hallo, gern! Die beiden Fehler stehen nicht direkt in Beziehung und lassen sich auch nicht auseinander ausrechnen. Hier ein Link, wo das ganz gut (ganz unten) auch mit einem Bild erklärt ist: http://elearning.tu-dresden.de/versuchsplanung/e35/e2861/e2862. Signifikanzniveau und Irrtumswahrscheinlichkeit werden machmal als Begriffe für den gleichen Sachverhalt benutzt. Das Signifikanzniveau Alpha ist aber der Wert, den man sich vor der Datenanalyse als Grenze setzt, ab wann ein p-Wert signifikant ist oder nicht (meist 0,05). Die Irrtumswahrscheinlichkeit p (der p-Wert) ist dann der Wert dieses Fehlers in einem bestimmten durchgeführten Test. Dieses p wird mit alpha verglichen um zu entscheiden, ob der Test signifikant ist oder nicht.

Hallo Daniela,

vielen Dank für die super schnelle Antwort :-)! Das heißt alpha und beta Fehler sind also unabhängig, oder? Und Signifikannievau alpha = Irrtumswahrscheinlichkeit p, oder kann man das nicht so sagen und es muss heißen(pa)?

Viele Grüße

Hallo Katja,

ja, alpha und beta sind unabhängig und alpha=p (wenn man es so formulieren will).

Schöne Grüße

Daniela